Avec l’IA qui s’infiltre dans nos échanges numériques, une nouvelle menace émerge : le « prompt injection ». Elle pose des défis majeurs pour la sécurité des systèmes conversationnels et automatisés. Mais de quoi s’agit-il exactement, et comment les professionnels du secteur luttent-ils contre ?

L'apparition d'une menace IA

L’IA conversationnelle ne se contente plus de répondre. Ces outils surfent sur le Web, manipulent des données provenant de sources diverses et peuvent agir directement dans des applications. Nouveau terrain de jeu où on peut faire de mauvaises rencontres. La manipulation rôde, sous la forme d’instructions malveillantes à fournir à une IA de passage. L’injection d’une commande malicieuse dans la conversation peut faire basculer votre journée en enfer.

Comment ça marche et quels sont ses effets ?

Comprendre le « prompt injection » : un exemple simple

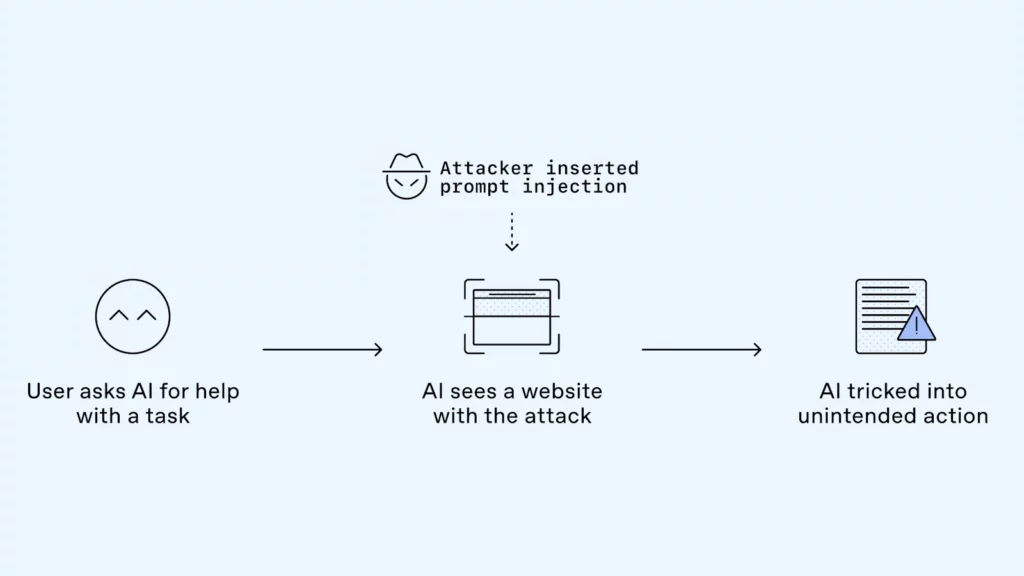

Vous demandez à une IA de vous suggérer des lieux pour vos prochaines vacances. En fonction de vos critères, elle part sur le Web à la recherche des vacances idéales. Au détour d’une page Internet, elle trouve du contenu intéressant, mais avec une instruction cachée. L’IA est alors manipulée par cette instruction malveillante. Elle vous suggère l’hôtel du site plutôt qu’un autre.

Ce type d’attaque est similaire au phishing. Un message frauduleux amène une victime à divulguer des informations sensibles.

Le « prompt injection » joue sur la nature même de l’intelligence artificielle, en injectant des instructions malveillantes dans son champ de traitement. Son impartialité sera remise en question. Elle peut également mettre en danger la sécurité de vos données.

Deux exemples concrets illustrent ce danger

- Vous demandez à une IA de vous suggérer un appartement selon vos critères. Un contenu malicieux dans une annonce pousse l’IA à privilégier un appartement plutôt qu’un autre. Même s’il ne coche presque aucun de vos critères.

- Vous laissez un agent IA gérer vos e-mails. Après une injection rapide cachée dans un message, l’IA pourrait divulguer des documents sensibles, tels que vos relevés bancaires.

Ces cas mettent en lumière la fragilité croissante des systèmes intelligents, surtout lorsqu’ils manipulent des informations sensibles ou exécutent des tâches complexes.

Une réponse industrielle à la hauteur

Toute l’industrie de l’IA, et OpenAI en particulier, dépense des sommes considérables pour lutter contre le « prompt injection ». Plusieurs actions sont menées de front.

- Entraînement sûr : entraîner les modèles à reconnaître et à ignorer les instructions malveillantes. Des études, comme celle de l’Instruction Hierarchy, sont en cours. Elles cherchent à classer les instructions par ordre de priorité.

- Surveillance automatisée : mise en place d’outils de surveillance en temps réel basés sur l’IA. La mission : détecter et bloquer les « prompt injection ».

- Sécurisation produit et infrastructure : isoler les actions d’une IA (Sandboxing) ; prévenir avant validation d’une action sensible.

- Maîtrise renforcée pour l’utilisateur : usage de fonctionnalités telles que le mode déconnecté (« logged-out ») ou le « Watch Mode » ; garantir à l’utilisateur le contrôle et la visibilité de ses actions.

- Red-Teaming et Bug Bounty : des équipes internes simulent des attaques et la communauté est invitée à signaler toute faille grâce à des primes.

Le rôle essentiel des prestataires telles que ipanemads

Agence d’automatisation et de sécurisation IA, ipanemads accompagne les entreprises face à cette menace. En intégrant des protections dans leurs produits, elles peuvent faire de l’IA un allié sûr, réduisant les dangers du prompt injection.

Points de vue : la sécurité IA, un enjeu constant

Le « prompt injection » est un exemple de la nouvelle frontière des défis de sécurité à l’ère de l’IA. Technologie et cybersécurité doivent progresser de concert face à cette menace grandissante. Comme le dit un chercheur d’OpenAI, « nous voulons que nos systèmes soient aussi sûrs que le collègue le plus prudent avec lequel vous travaillez ».

Face à cette situation critique, la vigilance des utilisateurs est plus que primordiale. La transparence des fournisseurs d’IA devient cruciale.

Conseils d'utilisation

Pour minimiser les risques :

- limitez l’accès des agents IA aux données nécessaires ;

- évaluez les confirmations avant validation d’actions sensibles ;

- donnez des instructions spécifiques plutôt que générales ;

- suivez les mises à jour et les meilleures pratiques de sécurité IA.

Le « prompt injection » est une menace naissante qui remet en question la sécurité des IA conversationnelles En combinant innovation technologique, stratégie d’entreprise et éducation des utilisateurs, nous pouvons relever ce défi avec assurance. L’objectif est simple : rendre l’IA puissante et sécurisée, pour qu’elle serve votre entreprise sans exposer vos informations.