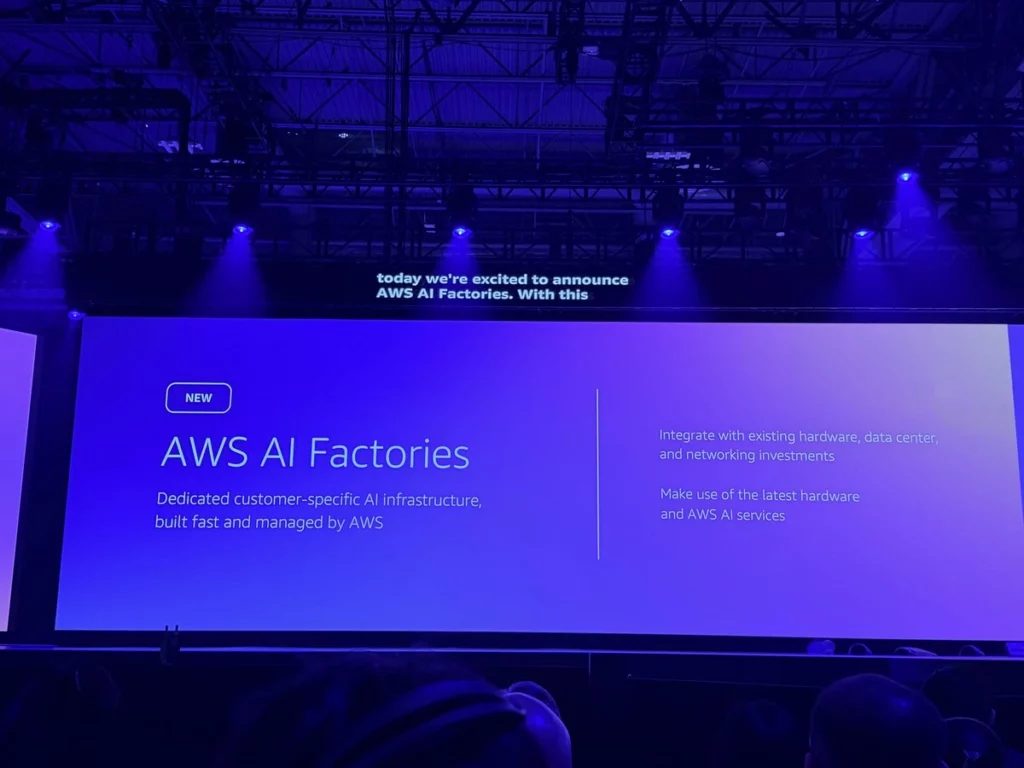

Comment les entreprises souhaitent associer performance IA et sécurité de données ? Une question qui revient toujours dans le milieu des professionnels de l’IA. Lors de son évènement Re:Invent, AWS lance AI Factories, une solution clé en main capable de rapprocher l’IA des infrastructures locales.

L'émergence des infrastructures IA sur site : un marché qui se développe

Les besoins en IA ne cessent d’évoluer, cependant il n’en demeure pas moins que, le cloud public a encore du mal à convaincre. En effet, cette technologie se heurte toujours à la question concernant le contrôle et la protection des données sensibles. L’innovation et la confidentialité restent donc deux sujets importants dans les directions informatiques.

Alors, comment bénéficier des avantages de l’intelligence artificielle, sans compromettre sa sécurité ? Pour répondre à cette question, AWS a mis en place les AI Factories. C’est une infrastructure IA entièrement managée, directement installée dans le datacenter client.

AI Factories : puissance et flexibilité au cœur des datacenters

Tout comme l’offre Outposts pour les Workloads classiques, AI Factories est une infrastructure capable de déployer matériel et logiciels dédiés dans le datacenter du client. L’objectif, pouvoir executer des agents et des applications IA directement dans les données de l’entreprise.

La pile matérielle et logicielle optimisée par AI Factories est composée de la dernière version du GPU Nvidia (Blackwell B200 et B300), des accélérateurs propriétaires Trainium, d’un réseau haut débit (Nitro, Elastic Fabric Adapter, UltraCluster) et des services tels que SageMaker et Bedrock.

Matt Garman, CEO d’AWS a affirmé lors d’un discours au Re:Invent 2025, que AI Factories était comme « région AWS privée ».

Des avantages stratégiques dans un marché très concurrentiel

AWS n’est pas la seule entreprise à proposer ce type d’offres. Par exemple, en mars dernier, Oracle a intégré des GPU Nvidia pour son offre Cloud@Customer managée sur site, et Microsoft l’a également fait pour son offre Azure Local. Quant à Google, il intègre progressivement Gemini dans son offre Cloud Distributed. Mais encore, l’infrastructure clé en main de AWS fait face à des solutions constructeurs à l’instar de HPE, Dell et Nvidia.

Matt Garman, CEO d’AWS a affirmé lors d’un discours au Re:Invent 2025, que AI Factories était comme « région AWS privée ».

Pour l’analyste Stephen Sopko d’HyperFrame Research : « Le secret réside dans le logiciel, et non dans l’infrastructure ». En effet, la maturité opérationnelle, l’intégration matérielle et logicielle sont un avantage pour AWS. Cependant, l’analyste insiste toutefois sur les coûts d’engagement plus élevés.

Selon Sopko : « L’offre Dedicated Region comparable d’Oracle requiert un engagement de cinq ans avec des dépenses annuelles minimales d’environ un million de dollars. Compte tenu des investissements d’infrastructure qu’AWS doit réaliser pour le déploiement du matériel, du réseau et de la gestion, je m’attends à des engagements pluriannuels similaires. »

Pour le moment, AWS n’a fourni aucune information sur les tarifs et les durées d’engagement des AI Factories.

IA d'entreprise : quel avenir pour les AI Factories ?

Les entreprises pourront ainsi opérer des changements en temps réel sur leurs modèles IA, ce qui permettra de renforcer leur agilité compétitive.

Matt Garman affirme : « AI Factories c’est la promesse d’une région cloud privée qui s’installe là où les données vivent, pour faire entrer l’IA dans le coeur des opérations ».